الأب الروحي للذكاء الاصطناعي يحذر من مستقبل مظلم.. ويقدم استقالته من غوغل!

هوية بريس – وكالات

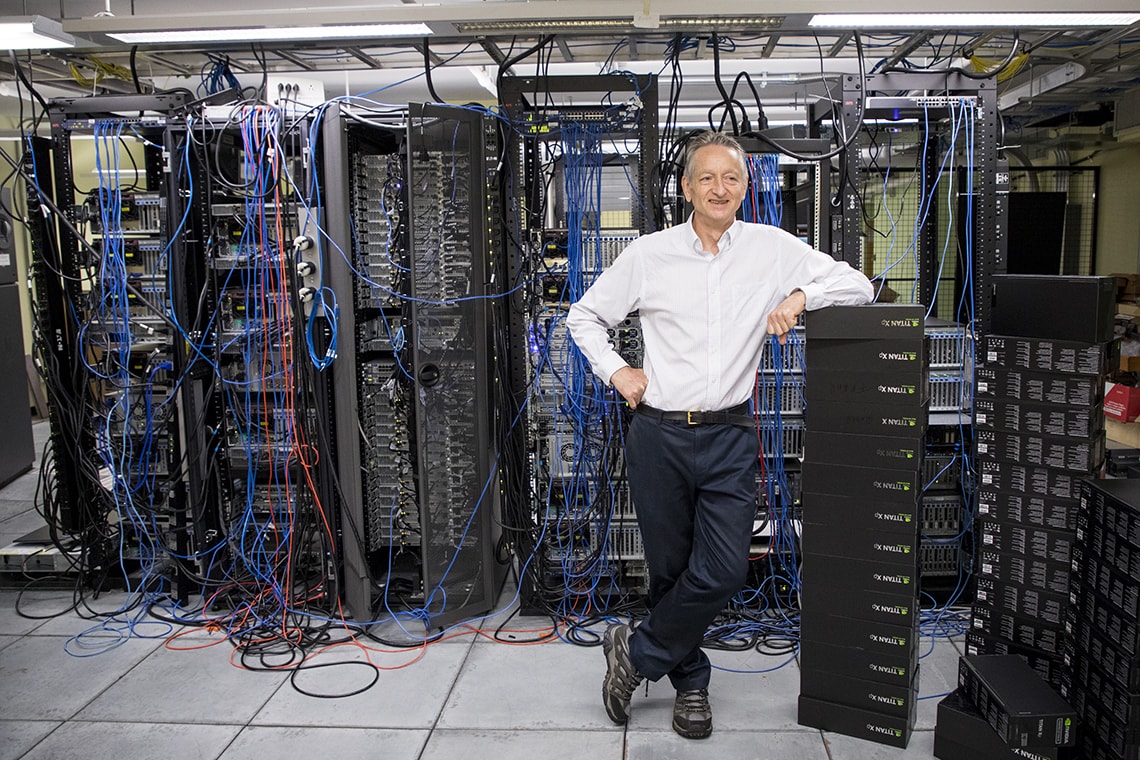

استقال جيفري هينتون، الذي يُعتبر الأب الروحي للذكاء الاصطناعي، من منصبه في شركة غوغل. وإذ حذّر هينتون من المخاطر المتزايدة للذكاء الاصطناعي، وشدد على أن “سلبيات برامج هذا القطاع كتشات جي بي تي مخيفة للغاية”.

عمل هينتون الرائد على الشبكات العصبية شكّل أنظمة الذكاء الاصطناعي التي تعمل على تشغيل العديد من المنتجات المعاصرة. لقد عمل بدوام جزئي في غوغل لمدة عقد من الزمن في جهود تطوير الذكاء الاصطناعي لعملاق التكنولوجيا، ولكن منذ ذلك الحين أصبح لديه مخاوف بشأن التكنولوجيا ودوره في تطويرها.

وفي تغريدة يوم الإثنين، قال هينتون إنه غادر غوغل حتى يتمكن من التحدث بحرية عن مخاطر الذكاء الاصطناعي، وليس بسبب الرغبة في انتقاد غوغل على وجه التحديد. وقال هينتون في تغريدة: “غادرت حتى أتمكن من التحدث عن مخاطر الذكاء الاصطناعي دون التفكير في كيفية تأثير ذلك على غوغل”. وأضاف: “لقد تصرفت غوغل بمسؤولية كبيرة”.

سرعة تطور الذكاء الاصطناعي

وفي مقابلة مع قناة “بي بي سي”، قال هينتون: “في الوقت الحالي، هذه البرامج ليست أكثر ذكاء منا، لكنني أعتقد أنها قد تكون كذلك قريبًا.” كما اعتبر هينتون أن عمره قد لعب في قراره بترك عملاق التكنولوجيا غوغل، قائلًا: “أنا في الخامسة والسبعين من عمري، لذا فقد حان الوقت للتقاعد”.

ومهدت أبحاث هينتون الرائدة للوصول إلى أنظمة الذكاء الاصطناعي الحالية، ولذلك يعتبره الكثيرون مؤسسًا لهذا القطاع. وفي مقابلة أخرى مع صحيفة نيويورك تايمز الأمريكية، قال هينتون إن “جزءاً مني نادم” على المساهمة في تطوير هذه التكنولوجيا.

لكن عالم النفس المعرفي وعالم الكمبيوتر البريطاني الكندي قال لبي بي سي: “في الوقت الحالي، ما نراه هو أن أشياء مثل تشات جي بي تي تتفوق على الشخص في مقدار المعرفة العامة التي يمتلكها وتتفوق عليه كثيرًا. لكن من حيث التفكير يبقى الإنسان متقدمًا”.

إلا أنه يشير إلى أن “سرعة تطور هذه البرمجيات تدفعنا لنتوقع بأن كفاءته ستتحسن، لذلك علينا أن نقلق بشأن ذلك.” وكان هينتون قد اعتبر في مقال له بصحيفة نيويورك تايمز أن هناك “جهات فاعلة سيئة” تحاول استخدام الذكاء الاصطناعي في “الأشياء السيئة”.

“كابوس”

وعندما سألته هيئة الإذاعة البريطانية للتوسع في هذا الأمر، أجاب: “هذا مجرد نوع من أسوأ السيناريوهات، إنه الكابوس”. وأضاف: “يمكنك أن تتخيل، على سبيل المثال، أن بعض الفاعلين السيئين مثل الرئيس الروسي فلاديمير بوتين قرر منح الروبوتات القدرة على وضع أهداف خاصة بها خلال الحرب.”

وتابع قائلًا: “لقد توصلت إلى استنتاج مفاده أن نوع المعلومات التي نطورها مختلف تمامًا عن المعلومات الاستخباراتية التي لدينا. فنحن أنظمة بيولوجية وهذه أنظمة رقمية”.

وعن طريقة تعلّم هذه البرمجيات، أوضح هينتون أنها “تعمل بشكل منفصل إلى أنها تشارك معرفتها على الفور، كما لو كان لديك 10000 شخص وكلما تعلم شخص ما شيئًا، يعرفه الجميع تلقائيًا. وهكذا يمكن لبرامج الدردشة هذه أن تعرف أكثر بكثير من أي شخص واحد”.

وهينتون ليس أول موظف في غوغل يرفع راية حمراء بشأن الذكاء الاصطناعي. ففي يوليو/ تموز، فصلت الشركة مهندسًا ادعى أن نظامًا للذكاء الاصطناعي لم يتم الكشف عنه أصبح واعيًا، قائلًا إنه انتهك سياسات التوظيف وأمن البيانات.